"AI가 안 썼다" 증명해야 하는 시대...'인간 인증' 없인 글도, 음성도 의심 받는다

"AI가 안 썼다" 증명해야 하는 시대...'인간 인증' 없인 글도, 음성도 의심 받는다

[WEEKLY BIZ]

홍체 인식 등 생체 인식 기술도 발전

“인공지능(AI)을 사용한 부정행위로 몰려 과제 점수가 ‘0점’ 처리됐을 땐 심장이 떨어지는 줄 알았어요.”

미국 휴스턴다운타운대 학생 러 버렐(23)씨는 최근 작문 과제에서 0점을 받은 후 이렇게 말했다. 담당 교수는 AI 사용 감지 서비스 ‘턴잇인(Turnitin)’이 해당 과제가 생성형 AI가 작성한 것으로 판정했다는 이유로 이같이 점수를 매겼다. 하지만 과제를 직접 작성한 버렐씨는 과제 작성 과정에서 저장한 화면 스크린샷과 메모 등이 담긴 15쪽 분량의 증거 자료를 학교에 제출한 뒤에야 성적을 회복할 수 있었다. 이후 그는 과제를 낼 때 자신이 글을 쓰는 과정을 담은 영상까지 촬영해 제출한다.

지난달 17일 뉴욕타임스(NYT)에 소개된 이 같은 사례는 챗GPT와 같은 생성형 AI가 대중적으로 쓰이면서 최근 심심찮게 벌어지고 있다. 실제 영국 고등교육정책연구소 등이 지난 2월 대학생 1000명을 대상으로 한 조사에서 학생 92%는 “과제를 작성할 때 AI를 사용하고 있다”고 답했다. 지난해 53%에서 급등한 수치다. 연구소는 “AI 기술이 고도화되고 학생들도 AI 활용에 능숙해지는 상황이라 대학은 기존의 평가 방식을 재검토해야 한다”고 지적했다. AI 사용 탐지 서비스 ‘GPT제로’의 에드워드 티엔 최고경영자(CEO)는 “AI가 쓴 글인지를 판별하는 수요가 폭증하면서 이제는 ‘사람이 썼다’는 것을 증명해야 하는 시대가 됐다”고 했다. 생성형 AI가 사람의 언어·행동을 점점 더 정교하게 모방하면서, 글쓰기뿐 아니라 음성·영상 등 모든 디지털 콘텐츠의 진위를 따지는 ‘인간 증명’의 시대가 도래한 것이다.

◇AI 사용 감별, 정확도는 아직

최근 생성형 AI 확산으로 사람이 직접 제작한 콘텐츠인지를 가장 많이 따지는 분야 중 하나는 글쓰기 영역이다. 지난달 14일 미국 메릴랜드 볼티모어카운티대(UMBC)는 학생들이 교수들에게 과제를 제출할 때 구글 독스(Google Docs)를 활용하도록 권장했다. 구글 독스는 문서 작성의 시간과 수정 과정을 자동으로 기록하는 클라우드 기반 앱으로, 무분별한 AI 사용을 막기 위한 조치다. 학교 측은 “AI를 쓴 학생일수록 별다른 수정 없이 글을 복사해 붙여 넣을 가능성이 높다”며 “(추후) 작성 기록을 바탕으로 교수가 학생에게 특정 문장을 왜 수정했는지 구체적으로 물어볼 수도 있다”고 전했다. 하지만 AI가 생성한 장문의 글을 학생들이 긴 시간에 걸쳐 직접 타이핑하는 경우 등 구글 독스 이용법에도 허점이 있다고 학교 측은 인정했다.

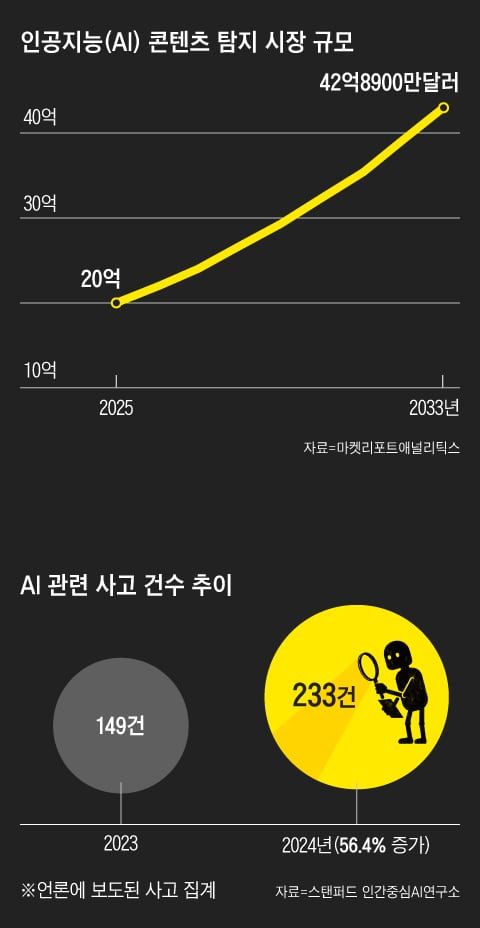

이에 AI로 생성한 텍스트가 아닌지 여부를 판별해 주는 업체도 성행 중이다. 시장조사 업체 마켓리포트애널리틱스(MRA)에 따르면 AI 콘텐츠 탐지 시장은 올해 20억달러에서 2033년 42억8900만달러에 이를 것으로 추산된다. MRA는 “교육, 언론, 법률 등 다양한 분야의 콘텐츠 제작에 AI가 활용되면서 탐지 설루션 수요가 더욱 증가할 것으로 예상된다”고 했다. AI 텍스트 탐지 서비스인 ‘GPT제로’ 이용자 수는 2023년 100만명에서 1년 새 400만명으로 늘었다.

하지만 판독 정확도는 아직 기대에 못 미치는 수준이다. 메릴랜드대 연구진이 AI 감지 서비스 12종을 평가한 결과, 평균 6.8% 확률로 인간이 작성한 글을 AI가 생성한 것으로 잘못 판별했다. 또 2023년 뉴욕대 아부다비(NYUAD) 연구에선 ‘GPT제로’와 오픈AI의 ‘AI 텍스트 탐지기’의 오판율이 각각 약 31%, 49%에 달했다.

이에 스탠퍼드대는 “AI 탐지기에만 의존해 AI 사용 여부를 판단하는 것은 권장하지 않는다”고 했고, 홍콩침례대는 자체 AI 탐지기까지 개발 중이다. 북미 소셜미디어 레딧(Reddit)에서는 AI로 작성한 글이라는 오해를 피하기 위한 경험담과 팁이 다수 공유되고 있다. 프리랜서 콘텐츠 작가라는 한 이용자는 “최근 한 고객이 내 콘텐츠가 AI 생성으로 감지됐다고 주장했는데, 라이브 영상 앱에 접속해 실시간으로 직접 콘텐츠를 제작하는 과정을 보여줬다”고 했다.

◇음성·영상으로 확장되는 인간 증명

생성형 AI 기술이 발전하면서 ‘인간 증명’의 필요성은 글쓰기 분야를 넘어 이제 음성·영상 등 시청각 영역으로까지 빠르게 확대되고 있다. 특히 딥페이크(AI를 활용한 불법 합성 콘텐츠) 기술이 발전하면서 일반인도 손쉽게 이를 제작할 수 있게 되자, 음성이나 영상의 진위를 따지는 일이 점점 더 중요해지는 추세다. 음성의 경우 AI가 특정인의 억양이나 말투는 물론 감정의 뉘앙스까지 정교하게 모방하는 수준에 도달하면서 보이스피싱과 같은 범죄 수법도 빠르게 진화하고 있다. 정보 보안 업체 핀드롭의 보고서에 따르면 딥페이크 음성 기반 사기 시도는 2003년 한 달 평균 한 건에서 지난해 들어 하루 평균 일곱 건으로 급증했다. 은행 텔레뱅킹이나 보험사 상담 과정에서 딥페이크 음성으로 본인 인증을 우회하거나, 가족·지인을 사칭해 송금을 유도하는 방식이 대표적이다. 딜로이트 금융서비스센터는 이러한 AI 기반 사기로 인한 피해액이 2027년까지 미국에서만 400억달러에 이를 수 있다고 추산했다. 이에 HSBC 은행 등 금융기관들은 AI가 생성한 음성의 파형과 주파수 등 미세한 차이를 분석해 인증 단계부터 AI 음성을 걸러내는 시스템을 도입하고 있다. 다만 핀드롭 측은 “AI 합성 음성을 실시간으로 탐지하는 기술은 아직 완벽하진 않은 상태”라고 했다.

딥페이크 영상 탐지 기술도 아직 갈 길이 멀다. 지난 3월 호주 연방과학산업연구기구(CSIRO)가 주요 딥페이크 영상 탐지 서비스 16개를 분석한 결과, 정상 원본 영상과 합성 영상을 구별한 정확도는 68% 정도에 불과했다. 특히 유튜브·인스타그램 등 소셜미디어에 올라오는 영상이나 유명인이 아닌 일반인 영상, 조명이나 해상도가 떨어지는 영상의 경우 판별 정확도가 크게 떨어졌다. CSIRO 연구팀은 “딥페이크 기술이 점점 정교해지고 있는 만큼, 단순히 겉모습만으로 판단하는 기존 방식으론 한계가 있다”며 “앞으로는 (콘텐츠의) 문맥과 의미까지 포함해 다차원적인 탐지가 필요하다”고 했다.

◇생체 인식 기술 고도화

딥페이크 영상이나 AI 음성 사기 등 인간을 정교하게 흉내 내는 기술이 빠르게 퍼지면서 ‘진짜 사람’을 가려내기 위한 생체 인식 기술도 주목받고 있다. 개인 고유의 생체 정보를 활용해 AI가 넘을 수 없는 인증의 벽을 만들려는 시도다.

특히 얼굴이나 지문보다 오류 확률이 적다고 알려진 홍채 인식이 떠오른다. 홍채 무늬와 형태, 색상 등을 기반으로 한 신원 확인의 오류 가능성은 10억분의 1 수준으로, 지문(1만분의 1), 얼굴 인식(1000분의 1)보다 훨씬 낮다는 평가다. 이에 챗GPT를 개발한 오픈AI의 샘 올트먼 CEO와 그가 공동 창립한 툴스포휴머니티(Tools for Humanity·TFH)는 ‘오브’라는 홍채 스캔 장치를 개발해 직접 실험에 나섰다. 사용자가 오브에 눈을 비추면 장치는 얼굴과 홍채 정보를 인식해 이를 고유한 암호화 코드로 변환한 뒤 원본 이미지는 즉시 삭제하는 식이다. 사용자에게는 이 과정을 거쳐 ‘월드ID’라는 디지털 신원 증명이 발급된다. 에이드리언 루드위그 TFH 최고정보보안책임자(CISO)는 최근 WEEKLY BIZ에 “오브를 통해 인간임을 인증받은 사용자는 이후 온라인상에서 실명이나 개인 정보를 밝히지 않고도 특정 행위의 주체가 ‘한 명의 인간’임을 암호학적으로 증명할 수 있다”고 밝혔다.

올트먼은 “AI 시대엔 ‘인간이 인간인 것’을 디지털 공간에서 증명하는 일이 필수로 여겨질 것”이라며 “오브는 단순 인증을 넘어 투표, 금융, 정부 서비스 등에서 인간성을 보증하는 열쇠 역할을 할 수 있을 것”이라고 주장한다. 다만 민간 기업이 민감한 생체 정보를 확보하고 관리하는 데 대한 우려의 목소리도 나온다. 스탠퍼드대 인간중심 AI 연구소(HAI)의 글로벌 조사에 따르면 AI 관련 기업이 개인 데이터를 철저히 보호할 것이란 확신은 2023년 50%, 2024년 47% 등에 그쳤다. 여전히 대중의 절반 정도는 민간 기업의 개인 정보 수집·활용에 대해 불안함을 느끼고 있다는 뜻이다.